白嫖Groq平台算力

发布于: 2024-07-27

什么是Groq

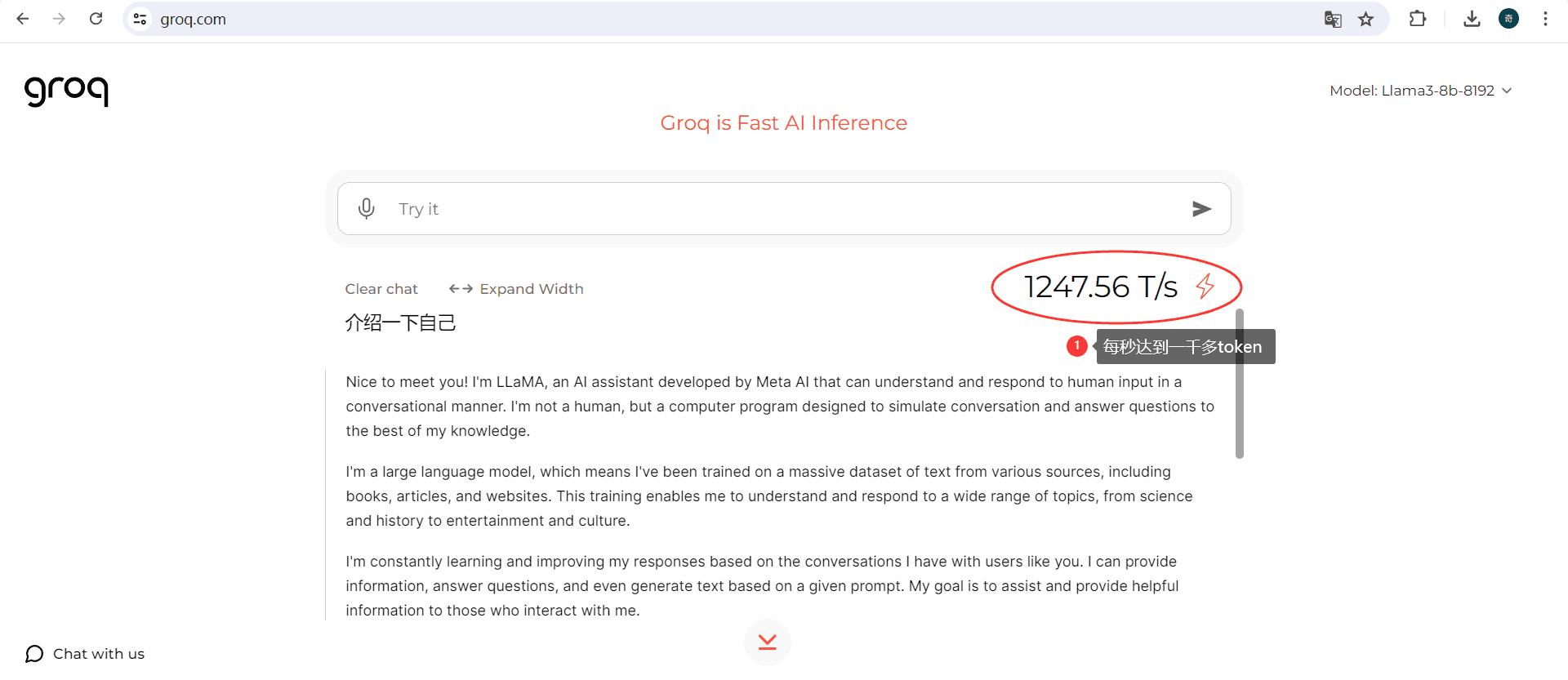

Groq是一家美国AI芯片公司,专注设计高性能的AI处理器,目前借助自研的AI芯片LPU,每秒能够输出近500个token。和GPT-4,Gemini对标,同一个问题所需的时间,Groq完全碾压了其他两者,输出速度比Gemini快10倍,比GPT4快18倍。

关于 Groq 的 LPU

Groq 创新的核心在于其 LPU,旨在以前所未有的速度加速 AI 模型,包括 ChatGPT 等语言模型。

LPU 推理引擎(LPU 代表语言处理单元™)是一种新型的端到端处理单元系统,可为具有顺序组件的计算密集型应用程序提供最快的推理,例如 AI 语言应用程序 (LLM) )。

LPU 旨在克服 LLM 的两个瓶颈:计算密度和内存带宽。就 LLM 而言,LPU 比 GPU 和 CPU 具有更大的计算能力。这减少了每个单词的计算时间,从而可以更快地生成文本序列。此外,消除外部内存瓶颈使 LPU 推理引擎能够在 LLM 上提供比 GPU 好几个数量级的性能。

与利用高带宽内存 (HBM) 的 GPU 不同,Groq 的 LPU 利用 SRAM 进行数据处理,从而显着降低能耗并提高效率。GroqChip 的独特架构与其时间指令集相结合,可实现自然语言和其他顺序数据的理想顺序处理。

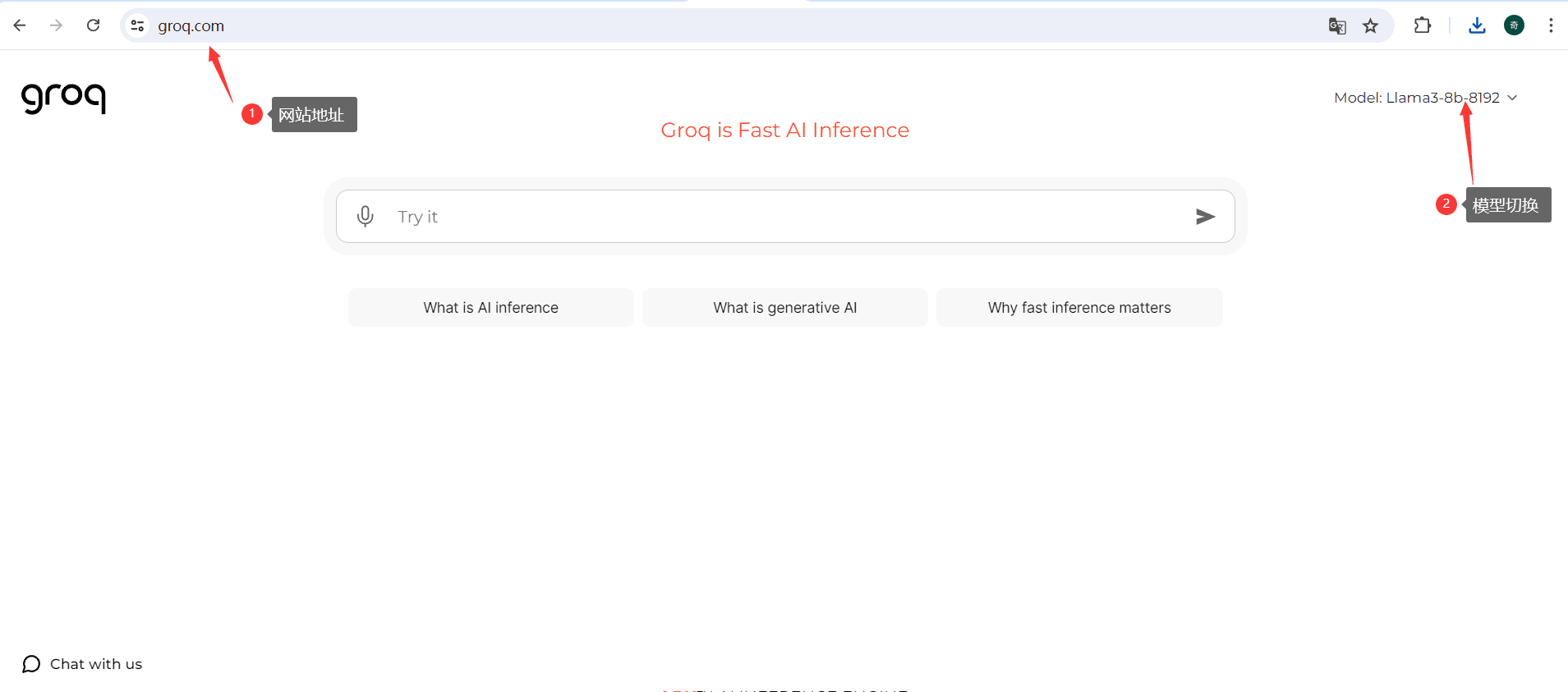

如何使用Groq

官方网站:https://groq.com/

看看生成速度

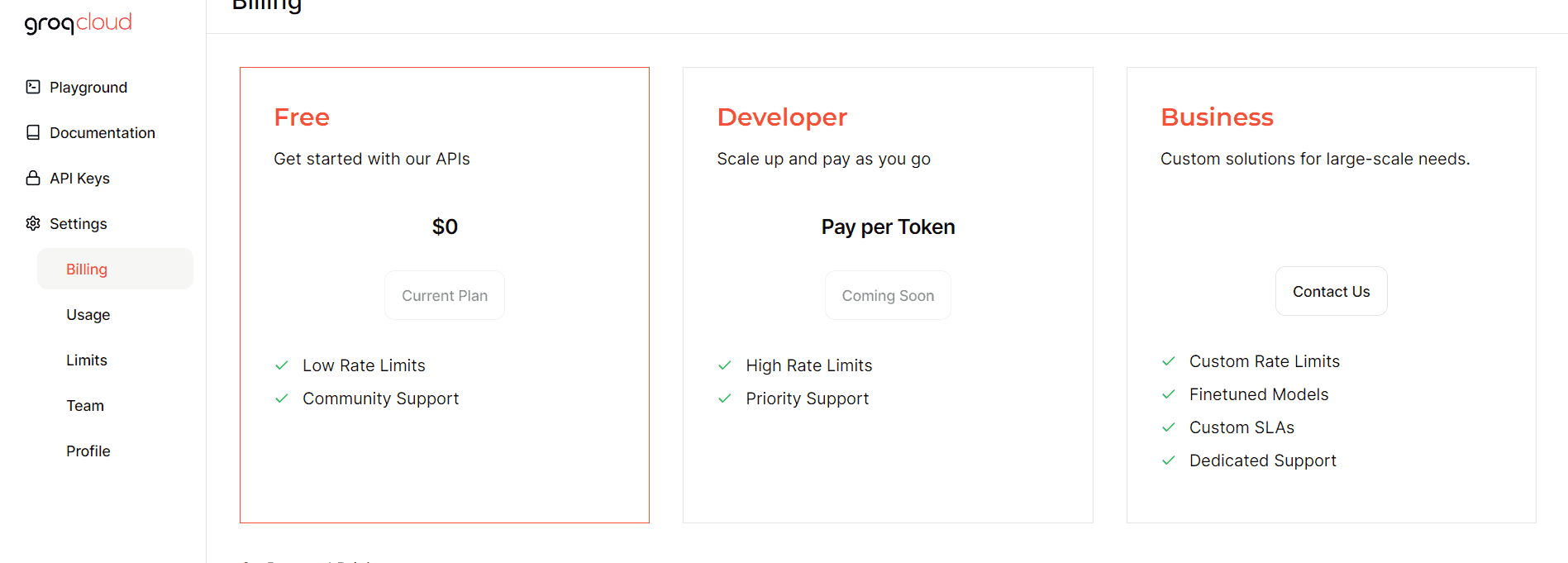

Api价格

Groq平台和其他平台一样我们可以申请免费apikey, 这些APIKEY也有一定的限制要求,主要是每分钟请求速率方面。

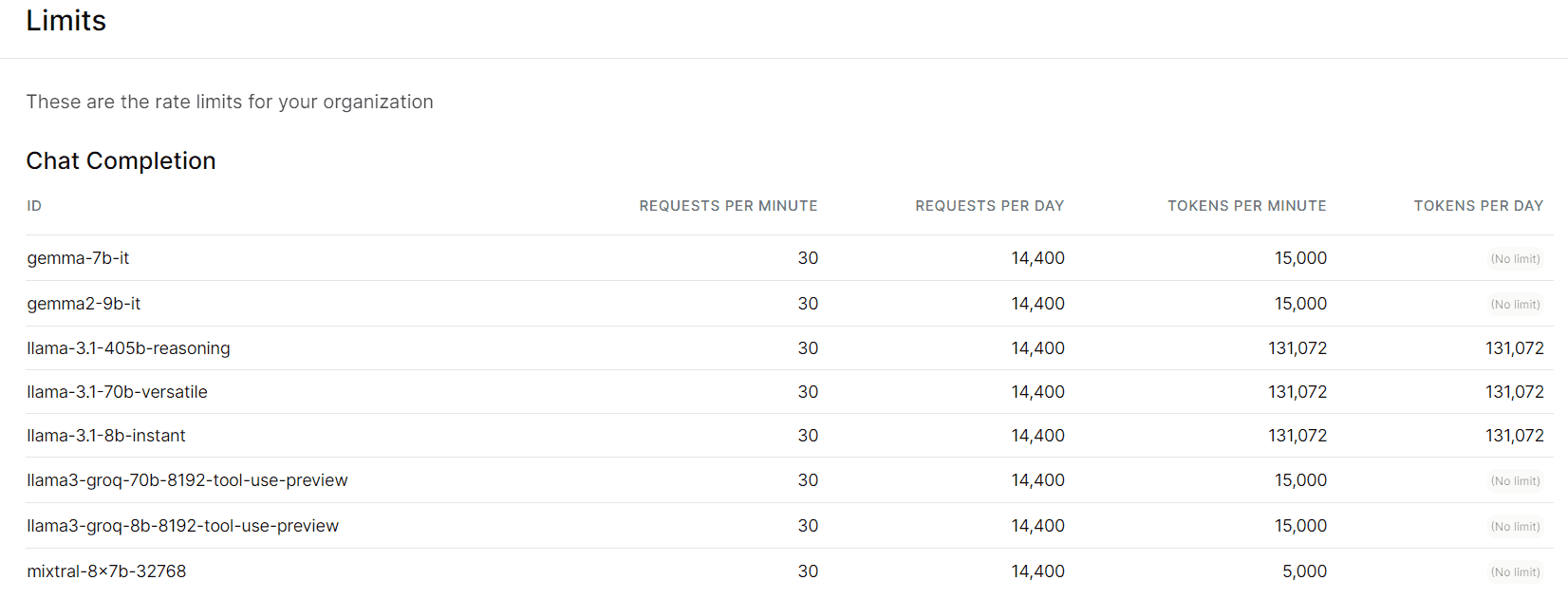

Groq平台提供个人免费的API-KEY接口,不同的模型限制如下

以gemma2-9b-it举例,每分钟30次request,每天14400次,每分钟15000tokens,每天token数不限制